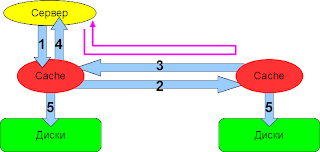

В данном посте кратко сформулирую преимущества Fibre Channel перед iSCSI. На рисунке ниже приведен пример передачи данных по FC сети между хостом и массивом.

Драйвер HBA "говорит" аппаратуре HBA где взять данные и куда их записать, в результате перемещение данных между памятью и сетью выполняет только HBA без использования ресурсов центрального процессора. HBA считывает блок данных из ОЗУ основной системы, инкапсулирует данные через уровни FC и пересылает в сеть поток пакетов. На другом конце сети RAID-массив выполняет аналогичные операции для записи данных на нужный диск (или диски). В этом случае данные никогда не приходят к приложению в "сыром" виде - они отображаются с помощью аппаратно реализованного менеджера томов (например, RAID 5), который определяет, на какие физические диски нужно записать конкретные блоки данных из потока.

Fibre Channel использует механизм группировки до 65 килобайт данных в последовательность (sequence). Последовательность пакетов является базовой единицей при передаче данных с использованием аппаратного ускорения, поэтому более сотни мегабайт данных можно передать через Fibre Channel HBA и при этом загрузка центрального процессора будет такая же, как при передаче только одного пакета Ethernet без применения аппаратного ускорения. Fibre Channel позволяет даже объединять последовательности в один обмен (exchange). Обычно каждая операция SCSI (чтения или записи) отображается в один exchange

Итого Преимущество 1: на обработку iSCSI требуются процессорные мощности. Обработка FC идет без использования ЦП.

На рисунке ниже показаны различия в пакетах передачи данных по протоколам iSCSI и FC.

Итого Преимущество 2: необоснованно большой размер заголовка в iSCSI пакетах по сравнению с FC.

Да, можно использовать jumbo-кажры - сверхдлинные Ethernet-кадры, которые используются в высокопроизводительных сетях для увеличения производительности на длинных расстояниях, а также уменьшения нагрузки на центральный процессор. Jumbo-кадры имеют размер, превышающий стандартный размер MTU: от 1518 до 16000 байт. Но в этом случае приходится использовать дорогие коммутаторы корпоративного плана.

Основным препятствием для распространения Ethernet как базовой технологии построения сетей хранения данных является относительно большое время задержки (близкое к 75 -80 микросекундам), которое возникает из-за особенностей стека TCP/ІР. В High-End системах при одновременном обращении к тысячам файлов это может стать серьезной проблемой.

Преимущество 3: нет задержек в сети

В целом, надо отметить, что основными недостатками технологии iSCSI являются именно необходимость в процессорном времени и возникновение задержек сети, что в совокупности может серьезно мешать непрерывности бизнеса.

Более подробно о FC можно почитать в Статье о FC

Детальное описание iSCSI представлено здесь на ixbt